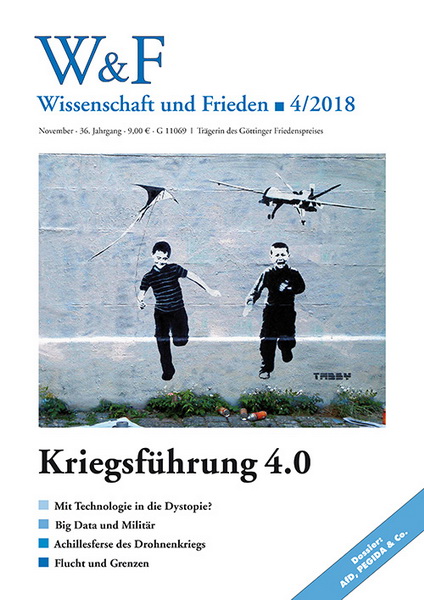

Mit Technologie in die Dystopie?

Ein Diskurs über konkrete und diffuse Risiken

von Frank Sauer und Thomas Gruber

Die Bedrohungsszenarien, welche heute im Zusammenhang mit neuen Technologien gezeichnet werden, sind erschreckend: vollständige und zuverlässige Überwachung durch intelligente Kamerasysteme, automatisiertes Töten mittels selbststeuernder Kampfdrohnen und empfindliche Cyberangriffe auf kritische Infrastrukturen, wie Krankenhäuser oder Kraftwerke. Dabei ist das konkrete Gefahrenpotential dieser Ansätze nur sehr schwer greifbar, denn Überwachung und Cyberattacken sind meist unsichtbar. Autonome Waffensysteme wiederum sind schon deshalb eine diffuse Bedrohung, weil ihre Entwicklung jetzt politisch bekämpft werden muss, obgleich sie bisher noch nicht existieren.

Die W&F-Autoren Frank Sauer und Thomas Gruber sind sich einig über die Notwendigkeit, diese Themen stärker öffentlich zu diskutieren und auf internationaler Ebene möglichst rasch einer Verrechtlichung zuzuführen. Ob die Nutzung neuer Technologien im Sicherheits- und Militärsektor immer weiter voranschreitet, unvermeidlich ist und zu einer dystopischen Zukunft führen wird, darüber gehen ihre Meinungen aber auseinander.

Rolle rückwärts in den Krieg der Zukunft

von Frank Sauer

Es herrscht dieser Tage insgesamt kein Mangel an Gedankenspielen über die Zukunft. Zahlreiche bedeutsame Prozesse, vom Klimawandel über die demographische Entwicklung bis hin zu den Fortschritten im Feld der »Künstlichen Intelligenz« (KI),1 werfen ihre Schatten voraus und werden (zumindest in Fachkreisen) mit Aufmerksamkeit bedacht. Woran es hingegen mangelt, sind informierte und unter breiter gesellschaftlicher Beteiligung geführte Diskussionen über die enormen anstehenden Herausforderungen sowie der politische Wille, sich diesen rechtzeitig aktiv zu stellen.

Auch mit Blick auf die Zukunft des Krieges existiert eine rege Fachdebatte. Befeuert wird diese ebenfalls von den Fortschritten im Feld der KI. In ihrem Zentrum steht derzeit die zunehmende »Autonomie« in Waffensystemen. Längst warnen nicht nur Expert*innen aus der Wissenschaft, sondern auch aus prominenten zivilen Technologieunternehmen – den Innovationsmotoren im Feld – unter großer medialer Aufmerksamkeit vor einem risikobehafteten Paradigmenwechsel in der Kriegsführung (FLI 2015, 2017). Denn vollautonome Waffensysteme würden nach ihrer Aktivierung mit Hilfe von Sensoren und Software selbständig, im Unterschied zu ferngesteuerten Systemen also ohne menschliche Kontrolle oder Aufsicht, den Entscheidungszyklus der Zielbekämpfung durchlaufen. Sie wären demgemäß auch bei »selection and engagement of targets« (Zielauswahl und -bekämpfung) der menschlichen Verfügungsgewalt entzogen, was erhebliche völkerrechtliche, ethische und sicherheitspolitische Risiken aufwirft (Amoroso et al 2018).

Seit 2014 befassen sich zudem die Vereinten Nationen (VN) in Genf bei den Konferenzen zur VN-Waffenkonvention mit der Frage, ob – und wenn ja, wie – eine Regulierung von Autonomie in Waffensystemen erwirkt werden kann (Sauer/Altmann 2014). Doch bisher deutet kaum etwas darauf hin, dass die Staatengemeinschaft dem dringenden Regulierungsbedarf ernsthaft nachkommt (Mariske 2018).

Was droht, wenn die Entwicklung im Bereich der Autonomie in Waffensystemen unreguliert weitergeht? Was, wenn vollautonome Waffensysteme sowohl auf als auch jenseits der Schlachtfelder flächendeckend Einzug halten? Im Folgenden werden diese Fragen in Form drei zugespitzter Beschreibungen (Vignetten) adressiert.

Vignette 1: »Blitz-Krieg«

Vollautonomie in Waffensystemen wird global die Gefahr nichtintendierter Eskalationen zwischen Streitkräften erhöhen (Altmann/Sauer 2017), denn die Interaktionen zwischen vollautonomen Waffensystemen sind nicht vorhersehbar. Von den Finanzmärkten sind durch den Hochfrequenzhandel die Risiken solch unvorhergesehener Interaktionsprozesse zwischen zwei oder mehreren Algorithmen längst bekannt. Die dort vorkommenden »flash crashes« verursachen jedoch nur blitzartige Kursabstürze und somit finanzielle Verluste. Sollte hingegen ein kriegsvölkerrechtlich verbindliches und verifizierbares Verbot von vollautonomen Waffensystemen ausbleiben, dann droht der »flash war«, also eine Kaskade aus blitzartig autonom geführten Angriffen und Gegenangriffen, die in kürzester Zeit eine Eskalationsspirale in Gang setzen, ohne dass dem Menschen Zeit für einen korrigierenden Eingriff bleibt (Scharre 2018). Die Konsequenzen wären dann nicht mehr nur finanzieller Natur.

Der – langsame – Mensch ist, anders als Maschinen, dank seinem Verständnis von Kontext und sozialen Zusammenhängen der bessere Krisenmanager. Seine Kontrolle ist natürlich bisweilen Fehlerquelle, im Zweifel aber doch die überlegene Notfallsicherung. Eindrücklich belegt hat dies das Handeln des jüngst verstorbenen sowjetischen Oberstleutnants Stanislaw Petrow im Jahre 1983. Als das laut Diagnose fehlerfrei arbeitende sowjetische Frühwarnsystem eine Sonnenreflexion auf einer Wolke als Raketenflamme startender US-Interkontinentalraketen interpretierte und einen atomaren Erstschlag meldete, entlarvte Petrow dies als Fehlalarm und verhinderte so eine Kettenreaktion, die leicht in einem Atomkrieg hätte enden können. Zukünftig den gesunden Menschenverstand aus dem Entscheidungszyklus zu entfernen, bedeutet also, den »Blitz-Krieg« zu riskieren.2

Vignette 2: Normerosion

Vollautonome Waffensysteme werden die Erosion zentraler Völkerrechtsnormen beschleunigen. Die gegenwärtige Proliferation unbemannter, bisher noch ferngesteuerter, Waffensysteme markiert den Beginn dieses Trends. Rund 90 Staaten verfügen inzwischen über unbemannte fliegende Waffensysteme – »Drohnen«. Mindestens ein Dutzend Staaten verfügt über bewaffnete Drohnen, ebenso eine Reihe nichtstaatlicher Akteure, darunter der »Islamische Staat« und die Hisbollah. Da ferngesteuerte Systeme nicht das Leben von Pilot*innen riskieren und schwerer einem Akteur zuzuordnen sind, wächst mit ihrer Nutzung der politisch-militärische Handlungsspielraum. Mit anderen Worten: Es sinkt die Hemmschwelle, dort militärisch aktiv zu werden, wo bemannte Systeme zuvor zu mehr Vorsicht gezwungen hätten (Sauer 2014). Vollautonome Systeme werden diesen Trend weiter verstärken und das völkerrechtliche Interventionsverbot weiter untergraben.

Darüber hinaus werden vollautonome Waffensysteme das Kriegsvölkerrecht unterminieren. Auf maschinellem Lernen beruhende Maschinen können die für völkerrechtskonformes Operieren auf dem Schlachtfeld notwendigen Entscheidungen nicht treffen. Dazu gehört die Unterscheidung zwischen Kombattanten und Zivilisten, die Angemessenheit bei der Wahl der militärischen Gewaltmittel im Lichte des zu erreichenden militärischen Ziels sowie die Vorsicht bei der Durchführung des Angriffs, um Kollateralschäden zu vermeiden oder zu minimieren (Amoroso et al 2018, S. 23-24). Vollautonomie rührt darüber hinaus an den ethischen Grundfesten, auf denen das Völkerrechtssystem beruht, denn die Kompatibilität mit geltendem Recht ist das eine, das andere jedoch sind die diesem Recht zu Grunde liegenden Normen und Werte. Es verletzt die Würde des Menschen, Entscheidungen über Leben und Tod auf dem Schlachtfeld an Algorithmen zu delegieren (ICRC 2018), denn die auf diese Weise maschinell Getöteten werden damit zu Objekten im Ablauf einer Maschinerie degradiert. Für sie mag es zwar keinen Unterschied machen, ob ein Mensch oder ein Algorithmus ihren Tod bewirkt. Aber die Gesellschaft, die dieses »Outsourcing« erlaubt und mit dem Töten im Krieg ihr kollektives menschliches Gewissen nicht mehr belastet, gibt grundlegende zivilisatorische Werte und humanitäre Normen auf.

Vignette 3: Unterdrückung

Vollautonome Waffensysteme werden die Kontrolle und die Unterdrückung von Bevölkerungen erleichtern, und insbesondere autoritäre Regime werden sie nicht nur für die Kriegsführung nach außen, sondern auch im Inneren einsetzen. Aus Sicht eines autoritären Herrschaftssystems sind autonome Systeme nicht nur eine im Vergleich zu den üblichen Institutionen ungleich kosteneffizientere Lösung: Inlandsgeheimdienst, Polizei, Justiz, Gefängnisse, Militär, dies sind allesamt Organisationen mit Menschen, die ausgebildet, bezahlt und bestochen sein wollen (Roff 2016). Die automatisierte Unterdrückung ist zudem vor allem eines: verlässlich. Maschinen zögern nicht, haben keine Skrupel, planen nicht klammheimlich einen Coup. Ihre Wirkung auf den Menschen wird dabei natürlich nicht nur letal sein. Ein ganzes Spektrum von algorithmisch determinierten physischen und psychischen Vergeltungsmaßnahmen wird entwickelt werden, um die Bevölkerung in Schach zu halten. Gepaart mit Dauerüberwachung, Gesichtserkennung und einem »Social Credit System«, wie China es gegenwärtig testet (Lee 2017), bestraft die automatisierte Unterdrückung zukünftig tagein, tagaus, sieben Tage die Woche, 365 Tage im Jahr die Gesellschaft bereits für das kleinste Abweichen von der vorgegebenen Linie.

Schlussbetrachtung

Es muss – und es wird hoffentlich – nicht so kommen. Statt per Rolle rückwärts, in deren Zuge die Eskalationsrisiken des Kalten Krieges wiederkehren und bestehende Normen erodieren sowie neue, dringend erforderliche Regeln gar nicht erst geschaffen werden, kann die Menschheit sich die Zukunft auch anders erschließen: mit vorwärtsgerichteten Schritten. Bezüglich der Autonomie in Waffensystemen muss der erste Schritt in die Zukunft jetzt getan werden. Dabei sollten wir Menschen uns die Verfügungsgewalt über Waffensysteme bewahren.3 Ein internationales, völkerrechtlich bindendes und verifizierbares Verbot von Vollautonomie in Waffensystemen wäre dafür das am besten geeignete Mittel. Ein solches Verbot wäre nicht perfekt, es würde zukünftig von Einzelnen missachtet werden – das zeigt die Erfahrung, etwa im Falle der Chemiewaffen. Aber deswegen die Norm erst gar nicht zu etablieren, wäre fahrlässig, denn die Alternative, die dystopische Version der Zukunft, steht uns vor Augen. Es braucht nun den politischen Willen, sie Fiktion bleiben zu lassen.

Anmerkungen

1) Der Begriff der »Künstlichen Intelligenz« ist weit und nicht einheitlich gefasst. In Ermangelung einer feststehenden Definition wird darunter in der Regel eine Vielzahl unterschiedlicher softwarebasierter Techniken und Verfahren zur Automatisierung von Aufgaben subsumiert, die zuvor die Anwendung menschlicher Intelligenz erforderten. Im Folgenden wird auf den Begriff der KI weitgehend verzichtet und stattdessen die Autonomie von Systemen in den Mittelpunkt gerückt.

2) Dieser Abschnitt bedient sich bei Hansen/Sauer (im Erscheinen).

3) Siehe Amoroso et al. (2018) für einen Vorschlag, wie die Bewahrung menschlicher Verfügungsgewalt über Waffensysteme so ausgestaltet werden kann, dass Autonomie in Verteidigungssystemen zum Schutz von Soldatinnen und Soldaten gegen schnell anfliegende Geschosse weiterhin Verwendung finden kann.

Literatur

Altmann, J.; Sauer, F. (2017): Autonomous Weapon Systems and Strategic Stability. Survival, Vol. 59, No. 5, S. 117-142.

Amoroso, D.; Sauer, F.; Sharkey, N.; Suchman, L.; Tamburrini, G. (2018): Autonomy in Weapon Systems – The Military Application of Artificial Intelligence as a Litmus Test for Germany’s New Foreign and Security Policy. boell.de, 29.5.2018.

Future of Life Institute/FLI (2015): Autonomous Weapons. An Open Letter from AI & Robotics Researchers. futureoflife.org, 31.8.2015.

Future of Life Institute/FLI (2017): An Open Letter to the United Nations Convention on Certain Conventional Weapons. futureoflife.org, 25.9.2017.

Hansen, A.; Sauer, F. (im Erscheinen): Autonomie in Waffensystemen – Chancen und Risiken für die US-Sicherheitspolitik. Zeitschrift für Außen- und Sicherheitspolitik.

International Committee of the Red Cross/ICRC (2018): Ethics and autonomous weapon systems – An ethical basis for human control? icrc.org, 4.11.2018.

Lee, F. (2017): China – Die AAA-Bürger. zeit.de, 24.9.2018.

Marsiske, H.-A. (2018): Missing Link – Erfolglose Gespräche über Killerroboter. Dr. Frank Sauer im Interview: „Wir müssen mehr machen“. heise.de, 24.9.2018.

Roff, H.M. (2016): Autonomous Weapons and Incentives for Oppression. duckofminerva.com, 24.9.2018.

Sauer, F. (2014): Einstiegsdrohnen – Zur deutschen Diskussion um bewaffnete unbemannte Luftfahrzeuge. Zeitschrift für Außen- und Sicherheitspolitik, Vol. 7, No. 3, S. 343-363.

Sauer, F.; Altmann, J. (2014): Autonome Waffensysteme – Staatenkonferenz, 13.-16. Mai 2014, Genf. W&F 3-2018, S. 60-61.

Scharre, P. (2018): A Million Mistakes a Second. foreignpolicy.com, 24.9.2018.

Dr. Frank Sauer forscht und lehrt an der Universität der Bundeswehr München und twittert unter @drfranksauer.

So weit sind wir technisch nicht

von Thomas Gruber

Die Auswirkungen und Gefahren der »künstlichen Intelligenz« und damit einhergehende Technologien und Methoden der Kriegsführung sind bislang zivilgesellschaftlich wenig greifbar, staatlichen und militärischen Stellen scheint es aber wichtig zu sein, diese Nischen zu besetzen. In den letzten Jahren wurden weltweit militärische Kapazitäten für den Cyberkrieg geschaffen und die Drohnenflotten einiger Armeen stark ausgebaut und immer weiter automatisiert (wie etwa bei der Zielfindung oder der Flugstabilisierung). In vielen Städten wurde »intelligente« Videoüberwachung eingeführt, und die Forschung an solchen Überwachungssystemen wurde erheblich gefördert.

Eine kaum greifbare Bedrohung der Zivilgesellschaft auf der einen, staatliche und militärische Aufrüstung auf der anderen Seite – wie groß und vor allem welcher Art sind die Gefahren, die von diesen neuen Technologien und Methoden ausgehen?

Exkurs: Künstliche Intelligenz

Das Fachgebiet, welches sich mit der Entwicklung intelligenter Programme und Maschinen befasst, ist die Künstliche Intelligenz, kurz als »KI« bezeichnet. Bereits Mitte der 1950er Jahre weckte die Forschung zur KI das Interesse staatlicher und militärischer Geldgeber (Crevier 1993 und Nilsson 2014). Die Aussicht auf intelligente Programme und Maschinen lässt vor allem Institutionen wie die US-amerikanische Defense Advanced Research Projects Agency (DARPA) aufhorchen, die die Erforschung von Zukunftstechnologien für das US-Militär fördert. Bis heute können KI-Forscher*innen allerdings kaum nennenswerte Erfolge mit militärischem Nutzwert vorweisen. Dennoch ist »Intelligenz« in vielen ingenieurswissenschaftlichen Publikationen und konkreten technischen Entwicklungen derzeit ein äußerst beliebtes Buzzword.

»Intelligente« Videoüberwachung

Ein Beispiel für die Verwendung von KI-Methoden ist die intelligente Videoüberwachung, mit der in Zukunft ganze Städte, Stadtgebiete oder kritische Infrastrukturen automatisch überwacht werden sollen. Die polizeiliche und militärische Bildauswertung steht derzeit vor einem enormen Problem: Zwar wird der Weg für eine immer umfassendere Überwachung der Zivilgesellschaft politisch sukzessive geebnet, es fehlt aber an der Kapazität, die immer größeren Datenmengen zu verarbeiten. So würde für die Sichtung sämtlicher Überwachungsdaten einer Metropole weit mehr Personal benötigt würde, als das Budget der Stadt hergibt. Die Bürger*innen würden dann zwar abgefilmt, aber ein großer Teil des Materials würde nie von einem Menschen bewertet. Einen vermeintlichen Ausweg bietet hier die intelligente Videoüberwachung: Entweder unterstützend oder vollautomatisch soll sie aus den Bilddaten von Überwachungskameras etwa gesuchte Einzelpersonen anhand bekannter biometrischer Daten erkennen und verfolgen, verdächtiges Verhalten von Individuen und Gruppen ausmachen und bei den menschlichen Auswerter*innen schließlich Alarm schlagen können (Monroy 2018). Oft werden die Überwachungslösungen auch als lernfähige Systeme geplant; die Algorithmen sollen dann beispielsweise verdächtiges Verhalten oder Bewegungsmuster lernen und damit ihre Wirkung verbessern.

Politisch wird die intelligente Videoüberwachung einerseits mit den gleichen Argumenten verteidigt wie die klassische Videoüberwachung: Mehr Kameras bedeuten angeblich mehr Sicherheit. Klassische Videoüberwachung wirkt allerdings kaum präventiv, sondern hilft bestenfalls bei der Aufklärung eines Verbrechens. Eine Ausnahme ist die erhoffte Abschreckung, die allerdings bei Affekthandlungen oder gezielten Anschlägen eher gering ins Gewicht fallen dürfte. Die intelligente Videoüberwachung hingegen soll gefährliche Situationen schon im Entstehen erfassen, sodass eine Eskalation durch herbeieilende Polizist*innen oder Soldat*innen verhindert werden kann. Um diese neue Technik frühzeitig zu fördern, investiert die Bundesregierung aktuell große Summen in die Forschung zur intelligenten Bildverarbeitung, so etwa im »Forschungsprogramm für zivile Sicherheit«, für das seit dem Jahr 2007 knapp 600 Mio. Euro bereitgestellt wurden (BMBF 2018).

Ein Blick auf die Ergebnisse der deutschen Forschungsprojekte lässt die »Intelligenz« der Überwachungssysteme allerdings fraglich erscheinen:1 Objektverfolgung kann oft nur unter erheblicher Fehlertoleranz realisiert werden, Gesichtserkennung ist aufgrund der Häufigkeit falsch erkannter Personen meist nicht praktikabel, »gefährliche« Situationen werden anhand einfachster Bewegungsmuster identifiziert (beispielsweise Rundgänge einer Person in einer Bahnhofshalle, längeres Verweilen oder Gruppenbewegungen im Allgemeinen), und von wirklicher Lernfähigkeit sind die Algorithmen noch weit entfernt. Es ist daher unwahrscheinlich, dass intelligente Videoüberwachung in näherer Zukunft funktioniert. Das bedeutet allerdings nicht, dass von dieser staatlichen Überwachungsoffensive weniger Gefahr für die Zivilgesellschaft ausgeht: Die angeblichen Fortschritte in der intelligenten Bildauswertung werden derzeit als Argument genutzt, um die Überwachung öffentlicher Räume immer weiter auszubauen; gleichzeitig steigt mit der großen Fehleranfälligkeit der Methoden die Wahrscheinlichkeit, vollkommen grundlos verdächtigt zu werden (zusätzlich zum Generalverdacht, der durch Videoüberwachung ohnehin besteht).

Autonome Waffensysteme

Im Jahr 2017 wurde der eindrucksvolle Kurzfilm »Slaughterbots« ins Internet gestellt (FLI 2017a). Er zeigt ein fiktives Szenario, in dem bewaffnete Mikrodrohnen mithilfe von KI-Algorithmen Gesichter erkennen, selbstständig Wege finden und schließlich Zielpersonen töten. Die Mikrodrohnen werden günstig verkauft und bewegen sich in Schwärmen. Angepriesen vom produzierenden Rüstungskonzern finden sie bald Verbreitung und werden schließlich von Unbekannten genutzt, um beliebige Gegner*innen zu töten. Der Film wurde auf Initiative des Future of Life Institute (FLI) und des Informatikprofessors Stuart Russell verbreitet. Das FLI setzt sich schon seit Jahren für ein weltweites Verbot vollautonomer Waffensysteme ein – bisher vor allem mit großer Wirkung auf die Forschungsgemeinschaft und die Industrie (FLI 2015, 2017b). Auch von parlamentarischer Seite wurde kürzlich die Hoffnung genährt, dass autonome Waffensysteme bald verboten werden könnten. Im Jahr 2016 wurden in Genf Treffen zur UN-Waffenkonvention angeregt, die sich mit dem Verbot vollautonomer Waffen befassen sollten. Nach mehreren Treffen von Regierungsexpert*innen der knapp 90 beteiligten Länder wurde am 1. September 2018 schließlich klar, dass es vorerst keine völkerrechtlich verbindliche Erklärung zur Ächtung autonomer Waffensysteme geben wird. Eine Minderheit von Staaten – unter ihnen die USA, Russland, Deutschland und Frankreich – blockierten ein wirksames Verbot (Facing Finance 2018).

Während politisch also bereits um ein Verbot autonomer Waffen gerungen wird, sind die technischen Möglichkeiten, solche Systeme zu realisieren, erst ansatzweise vorhanden. Das wird allein durch die oben angesprochene Problematik der intelligenten Bildverarbeitung deutlich. Von autonom steuernden Drohnen wird erwartet, dass sie mindestens die automatisierte Videoüberwachung ermöglichen: Ziele in Bilddaten eigenständig suchen, erkennen und verfolgen. Zusätzlich müssten sie noch selbst steuern können – eine Aufgabe, die schon bei Autos schwer realisierbar ist, obwohl die Fahrzeuge bei ihrer Bewegung in der Ebene weniger Freiheitsgrade zu bewältigen haben als eine Drohne, die auch nach oben und unten fliegt.

Trotzdem sind die Warnungen vor autonomen Waffen und die Forderungen zu ihrer Ächtung kein politischer Alarmismus, denn die Autonomie wird in Waffensystemen bereits stückweise realisiert, die Wirtschaft und das Militär betreiben vielerorts einen erheblichen Aufwand, um Waffensysteme weiter zu automatisieren. Die teilautonomen Komponenten reichen bei Kampfdrohnen von einer einfachen automatischen Enteisung der Tragflächen über die etwas kompliziertere Kollisionsvermeidung bis hin zur äußerst fragwürdigen Zielerkennung mittels Mobilfunkdaten (wie sie die USA beispielsweise für ihre Drohnenangriffe nutzt; The Intercept 2015).

Cyberkrieg

Ein Thema, das über die letzten Jahre besonders viel mediale Aufmerksamkeit bekommen hat, ist der »Cyberkrieg«. Das Bedrohungsszenario, welches von Politiker*innen und Militärs diesbezüglich gezeichnet wird, ist enorm: Feindliche Staaten, Armeen oder Terrorist*innen könnten uns mithilfe von Viren ausspionieren, Identitäten stehlen und durch Hackingangriffe kritische Infrastrukturen lahmlegen. Auf Basis dieser Gefahrenlage wurden viele Kapazitäten für militärische Strukturen zur Verteidigung des Cyberraumes frei gemacht. So wurde etwa 2008 das NATO-Exzellenzzentrum zur gemeinsamen Cyberverteidigung gegründet, das die Fähigkeiten der NATO-Staaten im Cyberkrieg bündeln soll, 2017 bekam die Bundeswehr ein eigenes Kommando für den Cyber- und Informationsraum (siehe Marischka in dieser Ausgabe), und in den USA wird seit 2017 ein eigenständiges Cyberkommandos augestellt.

So drastisch die vorwiegend westlichen Politiker*innen und Militärs die Bedrohung für die Zivilgesellschaft darstellen, so verwunderlich scheint es doch, dass die schlimmsten Szenarien – wie gezielte militärische Cyberangriffe auf die Gesundheits- oder Energieversorgung eines Staates – nie Wirklichkeit wurden. Im Gegenteil: Der größte bekannte Cyberangriff auf die Energieversorgung eines Staates war die US-amerikanisch-israelische Stuxnet-Attacke auf das iranische Atomprogramm und sie war – gemessen an ihrem immensen Aufwand – aus amerikanischer und israelischer Sicht nicht unbedingt erfolgreich. In Wirklichkeit richten sich die meisten Angriffe im Cyberraum gegen Unternehmen sowie gegen staatliche und militärische Strukturen. Damit wurde auf den virtuellen Raum ausgeweitet, was es im wirtschaftlichen und nationalen Wettstreit schon immer gab: simple Eigentumsdelikte sowie geheimdienstliche Spionage und Sabotage (Denker 2016). Jene geheimdienstlichen und kriminellen Aktionen jedoch zu einem Cyberkrieg zu stilisieren, birgt weit mehr Gefahr für die Zivilgesellschaft als die Cyberangriffe selbst: Mit dem Militär drängt neben Polizei und Geheimdiensten eine weitere mächtige Institution in den vorwiegend zivil genutzten virtuellen Raum und versucht diesen zu vereinnahmen und zu kontrollieren. Außerdem senkt die Militarisierung des Cyberraumes die Schwelle zur militärischen Eskalation erheblich. Die deutsche Bundesregierung, das EU-Parlament und NATO-Generalsekretär Jens Stoltenberg haben bereits konstatiert, dass auf einen Cyberangriff auch mit einem konventionellen Militärschlag geantwortet werden könnte (Bundesregierung 2018, Europäisches Parlament 2012, Schiltz 2017).

Fazit

Die größte Gefahr im Zusammenhang mit intelligenten Systemen, autonomen Waffen und Cyberattacken scheint also weder von terroristischen Zellen noch von der Technik selbst auszugehen. Im Gegenteil: Viele Systeme und Methoden, die im Zusammenhang mit einer automatisierten und digitalisierten Form der Kriegsführung genannt werden, sind weder momentan realisierbar noch werden sie dies in absehbarer Zeit sein. Viel bedrohlicher als jene dystopischen Zukunftstechnologien ist daher die staatliche und militärische Vereinnahmung der Thematik, denn so wird einerseits erhebliches Eskalationspotential geschaffen – wie im Falle des »Cyberkrieges« –, andererseits wird Technik genutzt, die noch unausgereift, für den jeweiligen Zweck unzureichend und teils enorm fehleranfällig ist. Im Falle automatisierter Videoüberwachung kann das zu falschen Verdächtigungen führen, bei der automatisierten Zielsuche einer Drohne zur direkten Tötung von Zivilist*innen.

Anmerkung

1) Vergleiche dazu beispielsweise die Ergebnisse der Projekte »APFel«, »ASEV« und »CamInSens«.

Literatur

Bundesministerium für Bildung und Forschung/BMBF (2018): Sicherheitsforschung – Forschung für die zivile Sicherheit. bmbf.de.

Deutscher Bundestag (2018): Antwort der Bundesregierung auf die kleine Anfrage zur Cybersicherheit der Abgeordneten Stephan Thomae, Jimmy Schulz, Manuel Höferlin, weiterer Abgeordneter und der Fraktion der FDP. Drucksache 19/2307 vom 24.5.2018.

Crevier, D. (1993): AI – The Tumultuous History of the Search for Artificial Intelligence. New York: Basic Books.

Denker, K. (2016): Die Erfindung des Cyberwars. WeltTrends, Nr. 113.

Europäisches Parlament (2012): Entschließung des Europäischen Parlaments vom 22. November 2012 zu den EU-Klauseln über die gegenseitige Verteidigung und Solidarität: politische und operationelle Dimensionen.

Facing Finance (2018): Killer Roboter vorerst in Sicherheit. Presseerklärung vom 3.9.2018.

Future of Life Institute/FLI (2015): Autonomous Weapons: an Open Letter from AI & Robotics Researchers. futureoflife.org.

Future of Life Institute (2017a): Slaughterbots. youtube.com.

Future of Life Institute/FLI (2017): An Open Letter to the United Nations Convention on Certain Conventional Weapons. futureoflife.org.

The Intercept (2015): Documents: SKYNET – Applying Advanced Cloud-based Behavior Analytics. theintercept.com, 8.5.2015.

Monroy, M . (2018): Berliner Überwachungsbahnhof will jetzt auffälliges Verhalten erkennen. netzpolitik.org, 28.7.2018.

Nilsson, N.J. (2014): Die Suche nach Künstlicher Intelligenz. Berlin: Akademische Verlagsgesellschaft.

Schiltz, C. (2017): NATO-Generalsekretär: „Cyberangriffe können Bündnisfall nach Artikel 5 auslösen“. welt.de, 19.1.2017.

Thomas Gruber promovierte zum Thema »Mathematik, Informatik und moderne Kriegsführung«. Er arbeitet für das Forum InformatikerInnnen für Frieden und gesellschaftliche Verantwortung (FIfF) in der W&F-Redaktion mit.